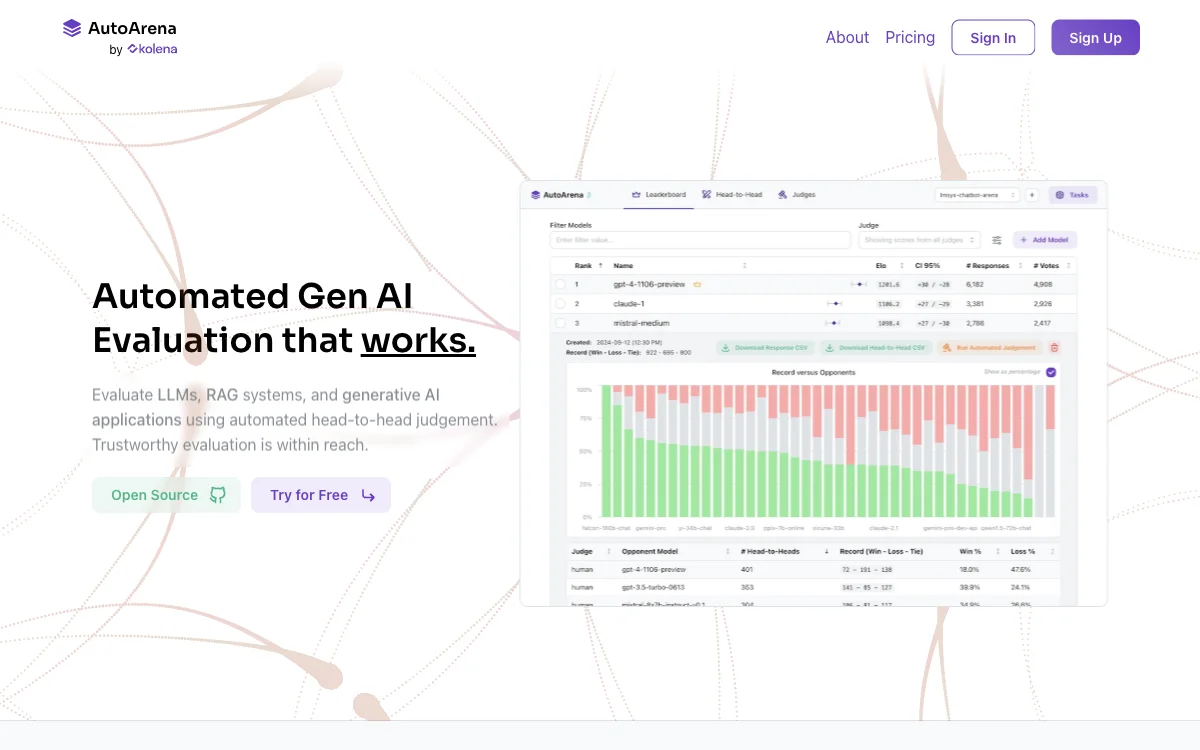

AutoArena, c'est le truc du siècle pour évaluer vos systèmes d'IA générative de manière ultra - automatisée. On peut tester les LLMs, les systèmes RAG et les applications d'IA générative en faisant des face - à - face automatisés. C'est top, parce que ça donne des résultats ultra - fiables.

La grosse force d'AutoArena, c'est l'utilisation des modèles juges. On peut choisir parmi ceux d'OpenAI, d'Anthropic, de Cohere, de Google et bien d'autres. Ces modèles sont bien plus performants en comparaison par paires que lorsqu'ils évaluent des réponses isolées. Et si tu veux, tu peux même utiliser des modèles juges open - weights via Ollama en local. C'est super flexible, quoi !

Ensuite, AutoArena transforme les votes face - à - face en classements grâce aux scores Elo et aux intervalles de confiance. Tu peux aussi utiliser des « jurys » de modèles juges LLM pour avoir un signal plus rapide, moins cher et plus précis. C'est un peu comme avoir une équipe de spécialistes qui évaluent ton système en un rien de temps.

AutoArena prend en charge tout le bordel technique : parallélisation, randomisation, correction des mauvaises réponses, retentatives, limitation de débit... Tu n'as pas à t'embêter avec tout ça, il s'en charge tout seul.

Et si tu veux personnaliser les choses, tu peux affiner les modèles juges pour des évaluations plus précises dans ton domaine. Tu peux collecter les préférences humaines via l'interface de vote face - à - face pour adapter les modèles juges à ta sauce. En plus, AutoArena s'intègre bien dans les environnements CI. Tu peux l'exécuter en local, dans le cloud ou dans une infrastructure privée. C'est le top pour évaluer ton système d'IA générative sans se prendre la tête.