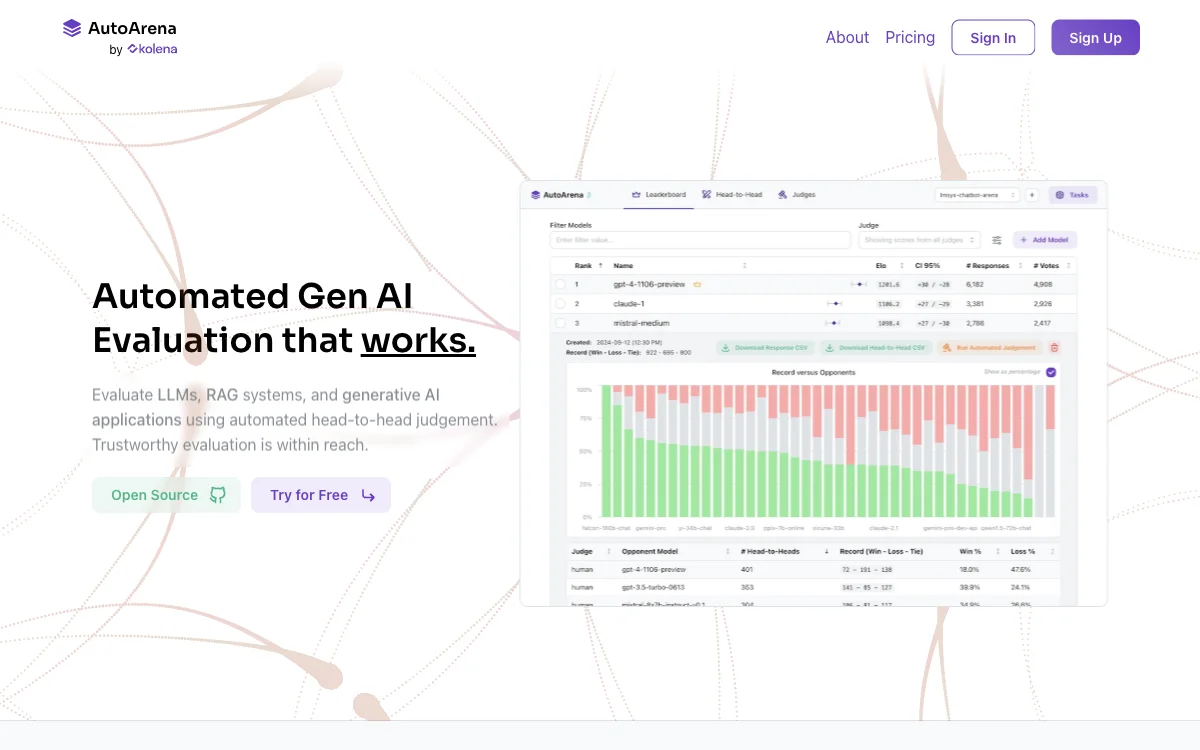

AutoArena é uma solução inovadora para a avaliação automatizada de Inteligência Artificial Generativa (Gen AI). Com essa ferramenta, é possível avaliar modelos de linguagem grandes (LLMs), sistemas de recuperação e geração de respostas (RAG) e aplicações de AI generativa por meio de julgamentos diretos e automatizados.

A avaliação direta usando modelos de julgamento oferece resultados confiáveis. A técnica de LLM - como - juiz é comprovada, e esses modelos geralmente performam melhor em comparações par a par do que ao avaliarem respostas individuais. Você pode usar modelos de julgamento de várias fontes, incluindo OpenAI, Anthropic, Cohere, Google e outros, ou modelos de julgamento de pesos abertos executados localmente via Ollama.

AutoArena converte vários votos diretos em classificações de tabela de líderes, calculando pontuações Elo e intervalos de confiança. A utilização de "júris" de juízes LLM fornece um sinal mais rápido, barato e preciso. Múltiplos modelos de julgamento menores, mais rápidos e baratos tendem a produzir um sinal mais confiável do que um único modelo de ponta.

A ferramenta cuida de tarefas como paralelização, aleatorização, correção de respostas ruins, repetição de tentativas e limitação de taxa. Isso reduz o viés de avaliação ao usar diferentes modelos de julgamento de famílias distintas, como GPT, Command - R e Claude. Além disso, você pode otimizar os modelos de julgamento para avaliações mais precisas e específicas do domínio.

Com AutoArena, é possível avaliar seu sistema de AI generativa no ambiente de integração contínua (CI). Configure automações no repositório de código - fonte para bloquear mudanças ruins em prompts, atualizações de pré - processamento ou pós - processamento, ou atualizações de sistemas RAG. A ferramenta pode ser executada localmente, na nuvem ou em uma implantação dedicada no local. Com apenas as entradas (prompts do usuário) e saídas (respostas do modelo) do seu sistema de AI generativa, você pode começar a testar em segundos.