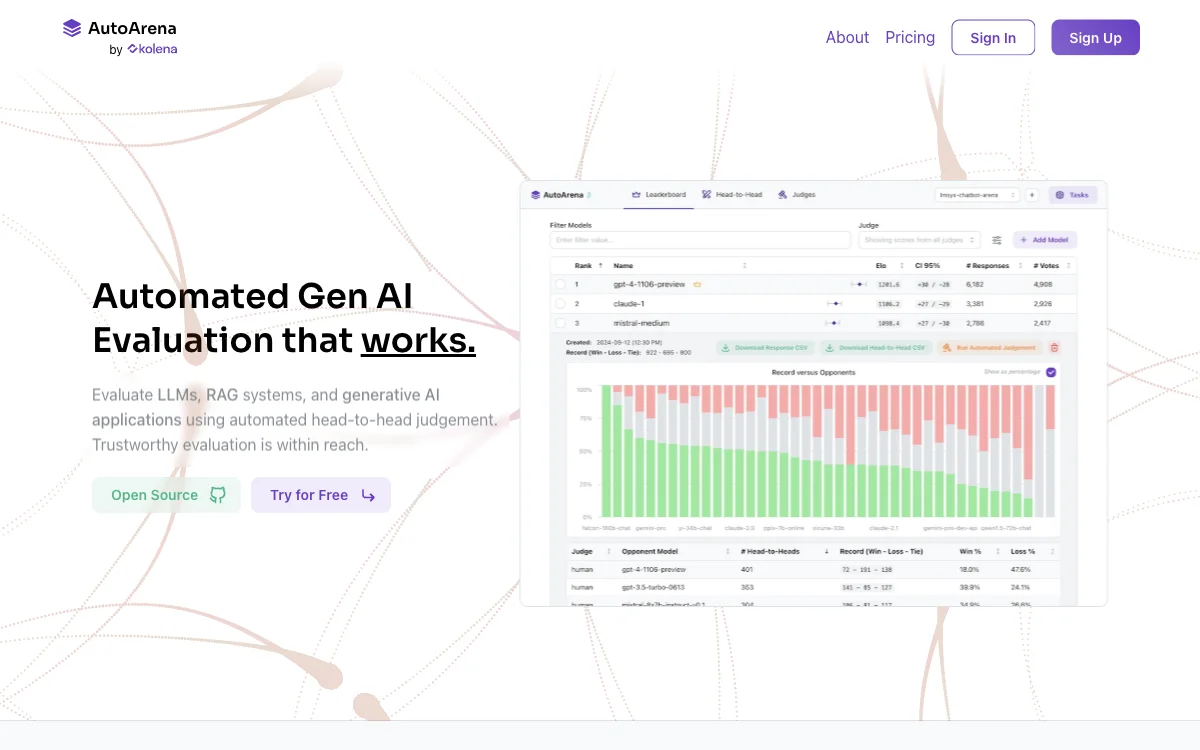

AutoArena是一款强大的自动化生成式AI评估工具,能对大语言模型(LLMs)、检索增强生成(RAG)系统以及生成式AI应用进行自动化的一对一评估。它采用先进的评估技术,利用裁判模型进行一对一评判,能得出值得信赖的评估结果。

在评估方法上,AutoArena支持使用来自OpenAI、Anthropic、Cohere等公司的裁判模型,也可使用通过Ollama本地运行的开放权重裁判模型。通过计算Elo分数和置信区间,它能将众多一对一投票转化为排行榜排名。此外,使用多个较小、快速且成本较低的裁判模型组成“陪审团”,能比单一前沿模型产生更可靠的信号。

AutoArena还具备诸多实用功能。它能处理并行化、随机化、纠正错误响应、重试、速率限制等任务,减少评估偏差。用户可对裁判模型进行微调,以实现更准确、特定领域的评估。通过API调用微调后的裁判模型或下载其权重,可自行运行。

在应用场景方面,AutoArena可在持续集成(CI)中评估生成式AI系统。用户能在源代码仓库中设置自动化,阻止不良提示更改、预处理或后处理更新,或RAG系统更新。它还能集成GitHub机器人,在拉取请求上进行评论。

AutoArena的部署方式灵活,可本地运行、在云端运行或进行专用的本地部署。安装简单,通过pip install autoarena即可在数秒内开始测试。测试仅需生成式AI系统的输入(用户提示)和输出(模型响应)。团队成员可在AutoArena Cloud上进行协作。