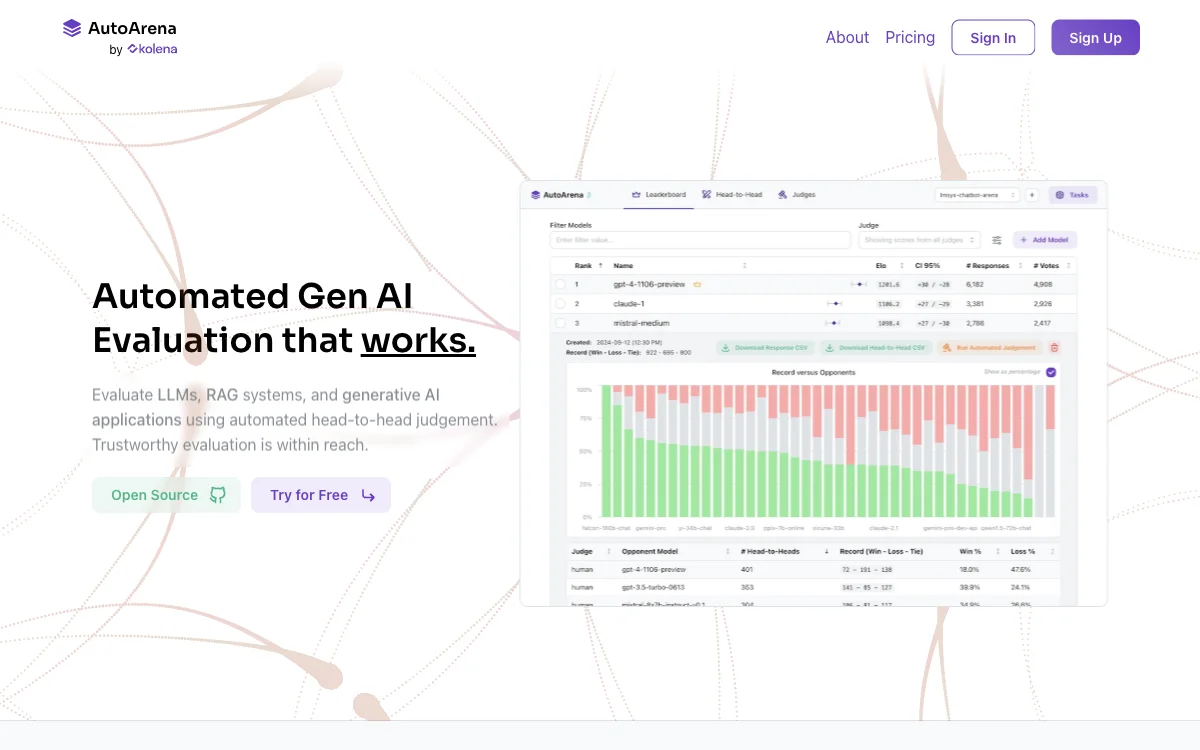

AutoArena은 자동화된 생성형 AI 평가를 위한 강력한 도구입니다. 이 도구를 사용하면 LLM, RAG 시스템 및 생성형 AI 애플리케이션을 자동화된 일대일 판단을 통해 평가할 수 있습니다. 일대일 판단을 위한 판단 모델을 사용하여 신뢰성 높은 결과를 얻을 수 있으며, 다양한 판단 모델을 활용해 평가 편향을 줄일 수 있습니다.

AutoArena은 여러 가지 판단 모델을 지원합니다. OpenAI, Anthropic, Cohere, Google, Together AI 등의 API에서 제공하는 모델뿐만 아니라, Ollama를 통해 로컬에서 실행되는 오픈 웨이트 판단 모델도 사용할 수 있습니다. 또한, 일대일 투표를 통해 Elo 점수와 신뢰 구간을 계산하여 리더보드 순위를 만들 수 있습니다.

이 도구는 병렬화, 무작위화, 불량 응답 수정, 재시도, 속도 제한 등의 작업을 자동으로 처리하므로, 사용자는 더 적은 시간과 비용으로 더 나은 평가를 수행할 수 있습니다. 또한, 판단 모델을 미세 조정하여 보다 정확하고 도메인 특화된 평가를 수행할 수 있으며, 일대일 투표 인터페이스를 통해 수집한 인간의 선호도를 활용하여 맞춤형 판단 모델을 미세 조정할 수 있습니다.

AutoArena은 CI에서 생성형 AI 시스템을 평가할 수도 있습니다. 소스 코드 저장소에서 자동화를 설정하여 나쁜 프롬프트 변경, 전처리 또는 후처리 업데이트, RAG 시스템 업데이트를 차단할 수 있으며, GitHub 봇을 통해 풀 리퀘스트에 코멘트를 남겨 시스템의 최신 버전이 이전 버전과 어떻게 비교되는지 확인할 수 있습니다.

AutoArena은 로컬, 클라우드 또는 전용 온-프레미스 배포에서 실행할 수 있으며, pip install autoarena를 통해 로컬에 설치하여 몇 초 만에 테스트를 시작할 수 있습니다. 테스트를 위해서는 생성형 AI 시스템의 입력(사용자 프롬프트)과 출력(모델 응답)만 필요합니다.